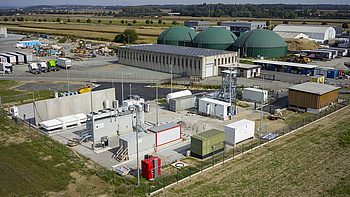

Die Kernfusion ist die große Hoffnung in der Energieversorgung. Allein sie scheiterte bis jetzt immer an einem technischen Problem: Fusionsmaschinen wie „Tokamaks“ konnten 100 Millionen Grad heißes Plasma zwar erzeugen, aber nicht lange genug in Schwebe halten. Der chaotisch brodelnde Wasserstoff touchierte nach wenigen Sekunden mit der Reaktorwand, der Fusionsprozess endete, bevor er richtig begonnen hatte. Jetzt scheint eine Lösung für das Schwebeproblem in Sicht. Die von Google-Alphabet um 500 Millionen Dollar gekaufte KI-Schmiede „Deepmind“ entwickelte einen lernfähigen Algorithmus, mit dem Plasmaverhalten vorhergesagt und ausbalanciert werden kann – mit Linzer KI-Technik. Im Forschungsreaktor am Schweizer Plasmacenter der École Polytechnique Fédérale de Lausanne konnte der Tokamak damit so geschickt angesteuert werden, dass das superheiße Plasma in elektrischen Feldern „eingehegt“ und stabil in Schwebe gehalten werden konnte – ohne Wandtouché.

Trickkiste der KI-Forschung

Zwar wurde der Prozess nach einigen Sekunden abgebrochen. Jedoch nicht aus Gründen der Instabilität, sondern, so hieß es von den Forschern in Nature , damit der Forschungsreaktor nicht überhitze. Für die Stabilisierung des Plasmastromes hatten die Forscher tief in die Trickkiste der KI-Forschung gegriffen. Sie schalteten alle für die Plasmaschwebe verantwortlichen Sensoren und Elektromagnete zu einem einzigen riesigen neuronalen Netzwerk zusammen und trainierten dieses mit Methoden des Linzer Informatikers Sepp Hochreiter. Der bayerische KI-Pionier, der seit 2006 an der Linzer Johannes-Kepler-Universität lehrt, entwickelte schon früh Konzepte fürs maschinelle Lernen. International berühmt wurde etwa seine Methode des „Long short-term memory“ (LSTM), mit der ein neuronales Netzwerk eine Art Kurzzeitgedächtnis entwickeln kann. In Kombination mit anderen von ihm entwickelten Methoden – etwa den „Exponential linear Units“ (ELU) können Maschinen dann schneller aus Fehlern lernen. Beide Methoden wurden nun von Deepmind für die „Plasmabändigung“ eingesetzt. „Das freut mich schon sehr“, sagt Hochreiter. „international wird man ja oft mehr wahrgenommen als vor der Haustüre.“

LSTM fast überall

Seit man mit „Big Data“ große Datenmengen verarbeiten kann, boomen Hochreiters KI-Methoden. Alle Tech-Giganten wie Google, Apple oder Amazon greifen darauf zurück. Google Translate basiert darauf ebenso wie die Spracherkennung von Apples „Siri“ oder Amazons „Alexa“. Auch Deepmind selbst setzte LSTM schon ein: für die Optimierung von Computerspielen oder für „Alpha-Fold“, einem KI-Programm, mit dem sich die dreidimensional gefaltete Proteinstruktur auf Basis von Aminosäuresequenzen vorhersagen lässt. In Lausanne trainierten sie nun mit LSTM und ELU das neuronale Netzwerk des Fusionsreaktors. Jede Millisekunde, die das Plasma länger schwebte, wurde dabei vom neuronalen Netzwerk als Datenpunkt für die Optimierung gespeichert. Jede Einstellung, die das Plasmaleben verkürzte, wurde von der KI gelöscht. Mit dieser Methode des „Reinforcement learning“ konnte die KI immer robuster und vorausblickendender agieren.

Für die Zukunft der Kernfusion könnte die neue KI-Methode entscheidend sein. 2025 soll der riesige Experimentalreaktor ITER im südfranzösischen Cadarache in Betrieb gehen. Bei ihm soll eine Kernfusion schon über 50 Minuten aufrechterhalten werden. Wird dieses Ziel erreicht, kämen bereits Kraftwerke auf Basis von Kernfusion in Sichtweite, die das Energieproblem nachhaltig lösen könnten. „Noch sind die neuronalen Netzwerke wahrscheinlich nicht robust genug“, meint Hochreiter, der selbst nicht an dem Projekt teilgenommen hat. „Prinzipiell lassen sie sich aber genau in diese Richtung weiterentwickeln. Ich wünsche den Kollegen jedenfalls alles Gute.“